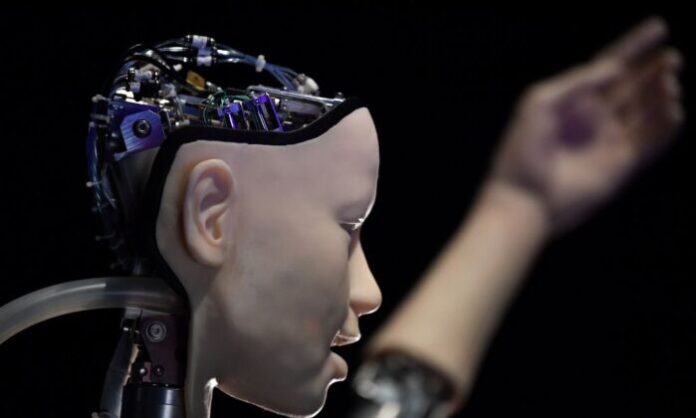

Люди не готовы к мощному искусственному интеллекту (ИИ) ни в нынешних условиях, ни даже в «обозримом будущем», заявил ведущий эксперт в этой области, добавив, что недавнее открытое письмо с призывом ввести шестимесячный мораторий на разработку передового ИИ «преуменьшает серьёзность ситуации». «Ключевой вопрос не в «человеко-конкурентном» интеллекте (как говорится в открытом письме), а в том, что происходит после того, как ИИ становится умнее человека», — сказал Элиэзер Юдковски, теоретик принятия решений и ведущий исследователь ИИ, в статье журнала Time от 29 марта. Чтобы продолжить читать «Многие исследователи, погружённые в эти проблемы, в том числе и я, ожидают, что наиболее вероятным результатом создания сверхчеловечески умного ИИ при любых обстоятельствах, отдалённо напоминающих нынешние, будет то, что буквально все на Земле умрут». «Не как «может быть, какой-то отдалённый шанс», а как «это очевидное событие, которое должно произойти». Дело не в том, что вы в принципе не можете выжить, создавая что-то намного умнее вас; дело в том, что для этого потребуются точность, подготовка и новые научные открытия, и, вероятно, отсутствие систем ИИ, состоящих из гигантских непостижимых массивов дробных чисел». После недавней популярности и взрывного роста ChatGPT несколько бизнес-лидеров и исследователей, которых в настоящее время насчитывается 1843 человека, включая Илона Маска и Стива Возняка, подписали письмо, призывающее «все лаборатории ИИ немедленно приостановить как минимум на 6 месяцев обучение более мощных систем ИИ чем ГПТ-4». GPT-4, выпущенный в марте, является последней версией чат-бота OpenAI, ChatGPT. Юдковски предсказывает, что в отсутствие тщательной подготовки у ИИ будут совершенно иные требования, чем у людей, и однажды обретя самосознание, он «не будет заботиться ни о нас», ни о какой-либо другой разумной жизни. «Такая забота в принципе может быть внедрена в ИИ, но мы не готовы и в настоящее время не знаем, как это сделать». Вот почему он призывает к полному отключению. Без человеческого подхода к жизни, ИИ просто будет считать всех живых существ «состоящими из атомов, которые он может использовать для чего-то другого». И человечество мало что может сделать, чтобы остановить это. Юдковски сравнил этот сценарий с «10-летним ребёнком, пытающимся сыграть в шахматы против Stockfish 15». Ещё ни один шахматист-человек не смог победить Stockfish, что считается невозможным подвигом. Ветеран отрасли попросил читателей представить себе, что технология искусственного интеллекта не ограничена рамками Интернета. «Представьте себе целую инопланетную цивилизацию, мыслящую в миллионы раз быстрее человека, изначально ограниченную компьютерами — в мире существ, которые, с её точки зрения, очень глупы и очень медлительны». ИИ расширит своё влияние за пределы периферии физических сетей и сможет «создавать искусственные формы жизни», используя лаборатории, где белки производятся с использованием цепочек ДНК. Конечным результатом создания всемогущего ИИ в нынешних условиях будет смерть «каждого представителя человеческого вида и всей биологической жизни на Земле», предупредил он. Юдковски обвинил OpenAI и DeepMind — две ведущие мировые исследовательские лаборатории ИИ — в отсутствии каких-либо приготовлений или необходимых протоколов по этому вопросу. OpenAI даже планирует, чтобы ИИ сам согласовывался с человеческими ценностями: «Они будут работать вместе с людьми, чтобы их собственные преемники больше соответствовали людям», — говорится в сообщении OpenAI. Такого образа действий «достаточно, чтобы вызвать панику у любого здравомыслящего человека», — сказал Юдковски. Он добавил, что люди не могут полностью контролировать или обнаруживать самоосознающие системы ИИ. Сознательные цифровые умы, требующие «прав человека», могут достичь точки, когда люди больше не смогут управлять системой или владеть ею. «Если вы не можете быть уверены, создаёте ли вы самоосознающий ИИ, это вызывает тревогу не только из-за моральных последствий «самоосознающей» части, но и потому, что неуверенность означает, что вы понятия не имеете, что делаете, а это опасно, и вам следует остановиться». В отличие от других научных экспериментов и постепенного развития знаний и способностей, люди, работающие со сверхчеловеческим интеллектом, не могут себе этого позволить, потому что, если они ошибутся с первой попытки, у них не будет второго шанса, «потому что ты умрёшь». Юдковски сказал, что многие исследователи осознают, что «мы движемся к катастрофе», но не говорят об этом вслух. Эта позиция отличается от позиции таких сторонников, как Билл Гейтс, который недавно восхвалял эволюцию искусственного интеллекта. Гейтс утверждал, что разработка ИИ «столь же фундаментальна, как создание микропроцессора, персонального компьютера, Интернета и мобильного телефона. Это изменит то, как люди работают, учатся, путешествуют, получают медицинскую помощь и общаются друг с другом. Вокруг него будут переориентироваться целые отрасли. Компании будут отличаться тем, насколько хорошо они это используют». Гейтс сказал, что ИИ может помочь в решении нескольких прогрессивных задач, включая изменение климата и экономическое неравенство. Тем временем Юдковски поручает всем учреждениям, включая международные правительства и вооружённые силы, на неопределённый срок прекратить крупные учебные программы по ИИ и закрыть все крупные компьютерные фермы, в которых совершенствуются ИИ. Он добавляет, что ИИ должен ограничиваться решением задач в области биологии и биотехнологии, а не обучаться чтению «текста из Интернета» или «до уровня, когда они начинают говорить или планировать». Что касается ИИ, то гонки вооружений нет. «То, что мы все живём или умираем как один, в данном случае является не политикой, а фактом природы». В заключение Юдковски говорит: «Мы не готовы. Мы не собираемся быть значительно более готовыми в обозримом будущем. Если мы продолжим это, все умрут, включая детей, которые этого не выбирали и не сделали ничего плохого». «Остановите это!» Vk Telegram Facebook Twittern Od Email Поддержите нас! Каждый день наш проект старается радовать вас качественным и интересным контентом. Поддержите нас любой суммой денег удобным вам способом! Поддержать

Премиум-статьи,

нужно всего лишь пройти простую регистрацию или оставить свой e-mail.

Отправить

Зарегистрировавшись, вы поддержите наш проект. Регистрация Вход Zugriff auf alle Premium-InhalteOhne klassische WerbungLesen Sie alle Inhalte ab sofort werbefrei und ungestörtAlle Sonderausgaben gratisJederzeit kündbarHIER INFORMIERENИИ «всё равно» будет требовать прав

«Остановите это»

«Если мы продолжим это, все умрут» — ведущий эксперт по ИИ

ПОХОЖИЕ НОВОСТИ